2015年6月18日

から hiruta

GCP Next Tokyoに参加してきました。 #GCPNext はコメントを受け付けていません

6/18 (木)に、六本木ヒルズ(アカデミーヒルズ49F)で行われた GCP Next Tokyoに参加してきました。GCP Nextはニューヨーク、サンフランシスコ、東京、ロンドン、アムステルダムで開催される世界規模のGCPのイベントになります。

GCP Next自体何年か前から開催されていましたが、当初は、40名程度でしたが、今年は、キーノート会場は満席、立ち見もある盛況ぶりでした。

HTC様のGCPを使った事例

デバイスの同期

デバイスの更新周期3年

デバイスを超えてアプリケーションを実行

少ない帯域でアプリケーションに対応

DCのレプリケーション

距離的に近いDCを選択

接続障害に対する耐性

アプリケーションは切断しても続行

上記課題に対して、GCPを使うことでどう解決したかの話

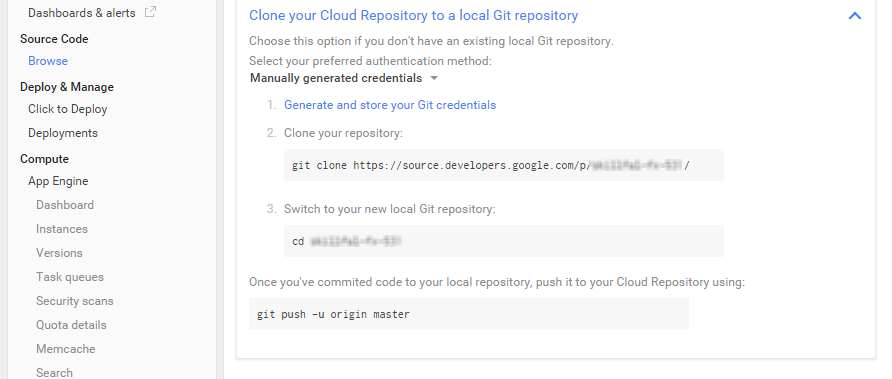

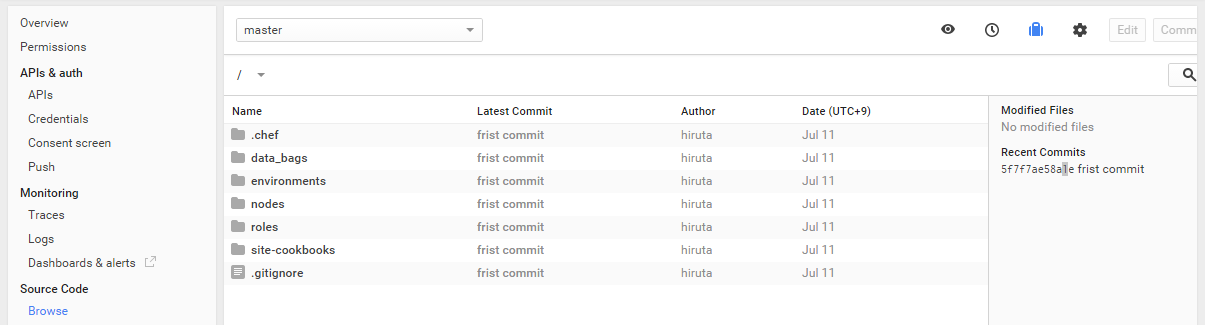

バージョンコントロール

push通知クライアント同期

差分だけを転送する

Googleの技術サポートはエンジニアが対応するので、きめ細かな対応も評価しているとのこと

pwc

消費型モデルをどう構築するか

GCPを選択した理由

分析の部分

重要な部分を担っている。セキュア、全体のトレンド

世界中にスケールするインフラが必要

今プランを策定しないと間に合わない

クラウドプラントフォーム一連のサービスがまとまっているもの

70 エッジローケーション

33カ国

レイテンシーの信頼性の高いネットワーク

500人のセキュリティエクスパート

ミッションインポッシブルの技術レーダーによる侵入検知

データを傍受して読むのも不可能

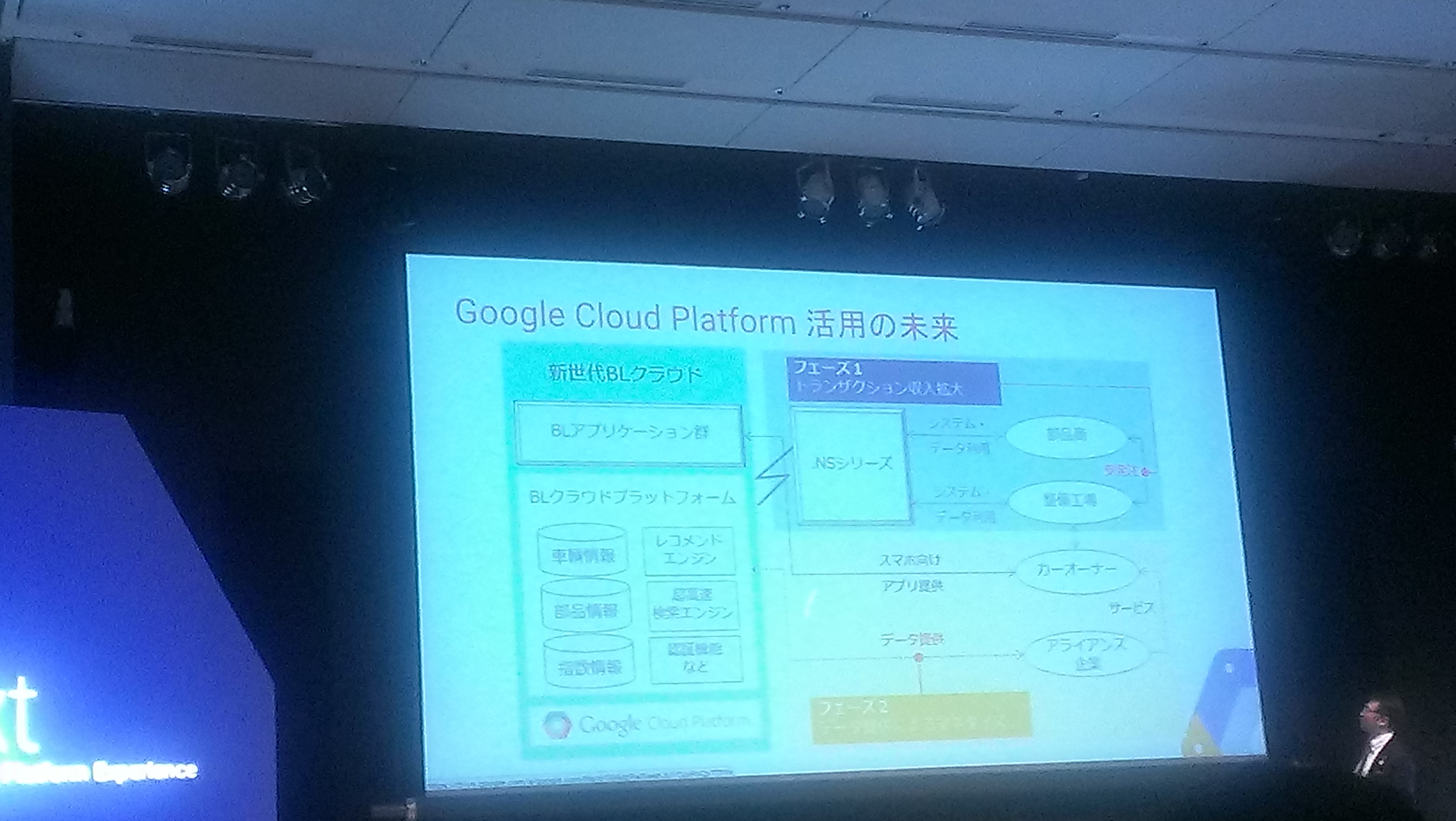

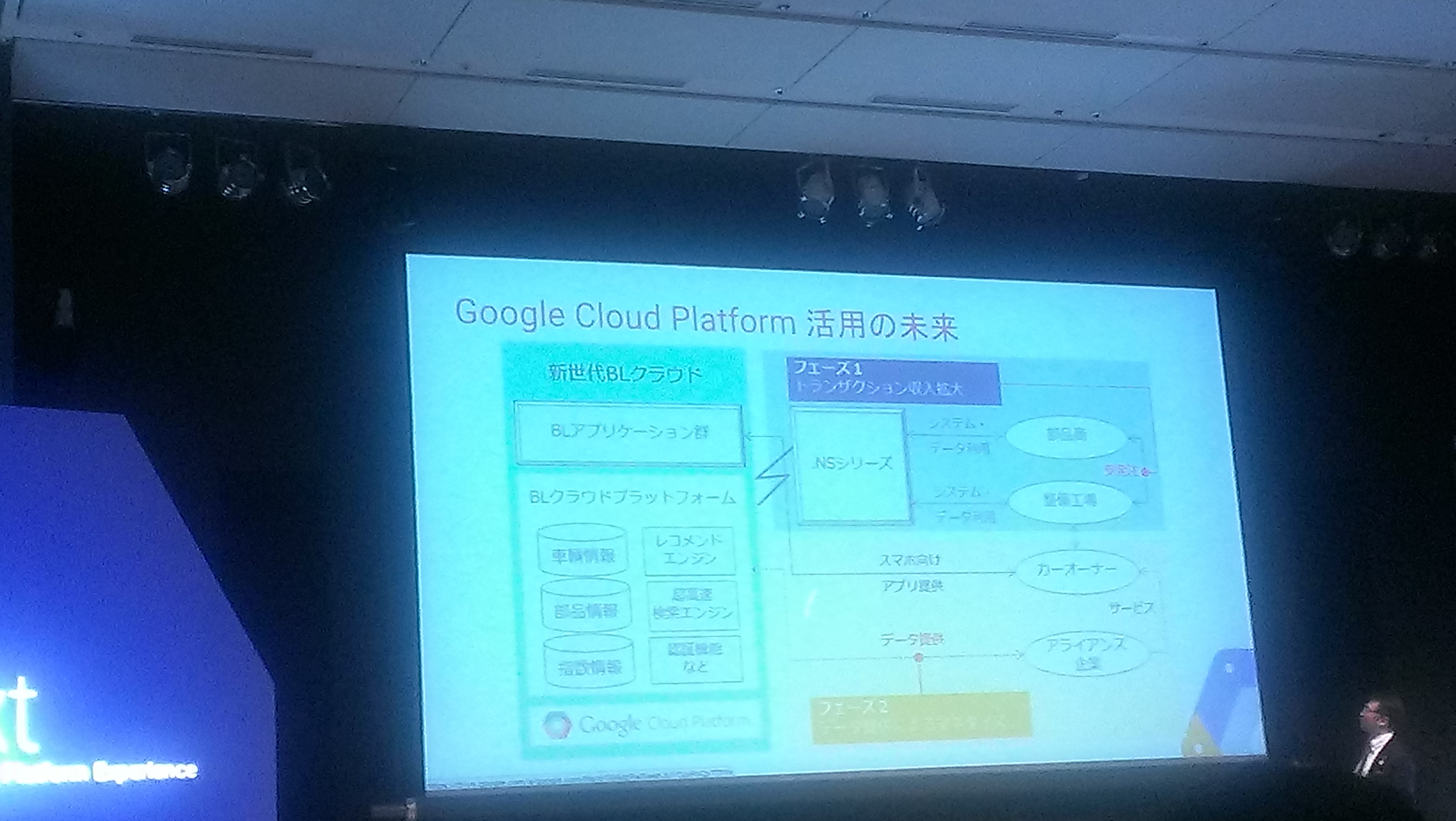

Broadleaf

なぜGoogleをインフラとして選択したか

当初は、自社のDCを構築

40,000万社を接続してコントロール

ネットワークで卸、工場を接続

AWSも検討したが、GCP上での動作実績のあるMEGALLANのミドルウェアがあるため、GCPを採用

Gooogleの方が拡張性に優れている、大量トランザクションに耐えうる。

こちらでも、サポートが優れている。通常では対応してくれないこともしてくれる

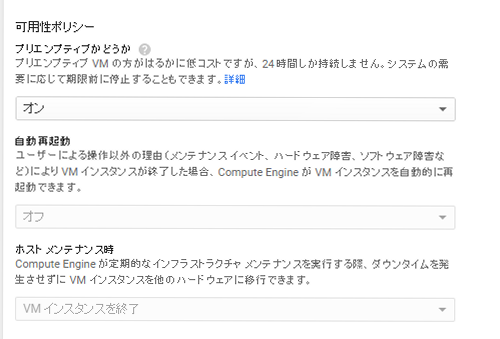

GCP移行後は、システム停止も発生していないとのこと(ライブマイグレーションなどメンテナンス不要にする機能も使えます。)

Groovenauts

最も速く、最も協力で最も質の高いクラウドプラットフォームで構築してきました。

くみ上げていく運用する時代の終焉

新しいビジネスに集中もできる。

クラウドは、やめるのも、使い続けるのも可能。新しいイノベーションも生まれやすい。

ここまでの午前中の部(キーノート)

午後は、ビジネストラック、デベロッパートラックに分かれてセッションがランチを挟んで続きました。

両者のうち、ビジネストラックを選択しました。

Engine入門

AppEngineは、PaaSの名もまだの時代に生まれたサービス。

Container Engineは、VMの依存性を解決するが、コンテナ間通信、セットアップ、ホスト間移動の課題を解決するために生まれた。

Compute Engine、i2.xlargeとn1-highmem-4を比較して、GCPのコストパフォーマンスの良さが話された。

Fastlyでは、リバースプロキシVamishを使って、4万リクエストを裁いてしまう。

Compute Engine自体インスタンス起動も秒単位。(AWSだと数分かかる)

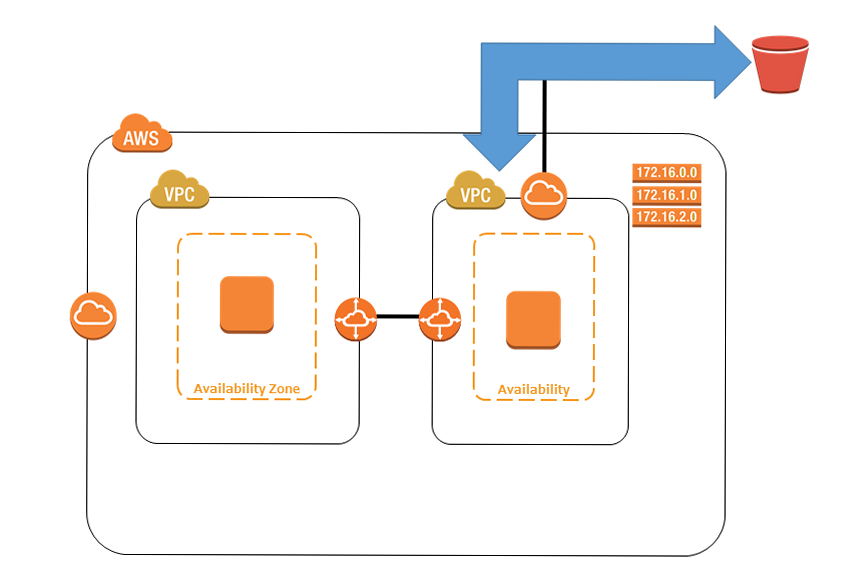

クラウドネットワーキング

長年15年投資してきた。光ファイバー

GCPは新しいけど、インフラは長年やってきました。

SDN

どこでもベストパフォーマンスが得られる

Direct Peering

PGP Peering

Private network 相互接続

公共インターネットを経由しない

パフォーマンスも予測しやすい

揺らぎに依存もしない

Carrier Interconnect

Service Providerを介してPeeringなしで接続

Equinix

Equinix Performace Hub

ISP, NSP

自分のキャビネットから

往復の遅延は低い

セキュリティ、コンプライアンスも維持

ビックデータ

データの世界がチェンジ

量が爆発的に増加 ログファイル、エンドポイント、デバイス

アーカイブも

データが10倍に

320億のIoTデバイス

リアルタイムでキャプチャしないといけない

クラウドベースのコンピューティング

ビックデータは複雑

Google NoSQLの導入したけど

Map Reduceでリーズナブルに分析ができない

コンピューティングリソースも必要

チャンスもあるけど、活用できない問題も

より使いやすくする

70%はインフラ構築等などに時間を費やしている

データをコンバージョンするときに時間を使えるようにする

経年劣化

速く使えばデータの可視も

SUNGARD、DeNAの事例について。

Tableau

当初はデータの可視化を目指す

自分でデータを見て、理解することを手助けるのがTableauの会社創立の使命とのこと

だれでも簡単にデータを分析することを目指す。

数字は瞬時に理解することはできない

グラフにして初めて理解できる。

Tableau Onlineは、Tableau Desktop、Tableau ServerのようにChorme、Safari等ブラウザ以外一切ソフト導入が必要としない。分析とかも問題なく利用可能。

年間サブスクリプション価格が、破格の60,000円。(支払いは年間一括。月額は現状ないが、検討してもらいたい)

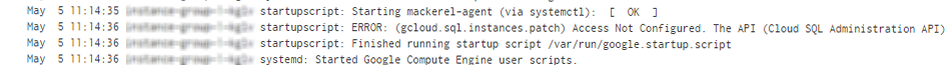

Tableauは、CloudSQLに接続することも可能。※credentialsには気をつける。tableauのデモの際にも、BigQueryに接続できないことがあった。

管理(Cloud Monitoring + Logging )

70%はメンテナンスの維持に使われている

イノベーションしたいとしても10%以下の現実

Cloud Monitoringはメンテナンスの手助けをしてくれる。

AWSでできないことも、GCPだと解決できることもあることがより実感できるイベントでした。