12/11 HPC on クラウドのセミナーに参加してきました。

HPC on クラウドを実現するビックデータ処理のご紹介

在庫管理、物流などをITで

さまざまなシステムが有機的につながっている

ITのリソースの用意 時間がかかっていた

購入、セットアップ

社内で稟議などで決めていた。無駄

必要名ときにプチとして使えないか

クラウドの原型

発電機をもつのが差別化要因では

電気を使って何を作っていくのが

大きなパラダイム

必要なときに使う。より速く、簡単に、安くを実現

今まで出来なかったことができるようになる

改善、イノベーションも

2006/3/14 Amazon S3発表

去年は280

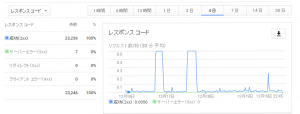

今年は、500を超える位の新機能の追加

EC2使用率 年率99%の成長率

いろんなIOS9001等の認証を取得

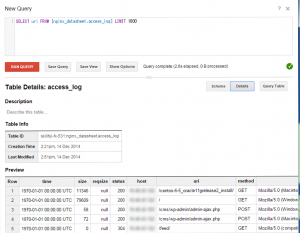

StartClusterをOnc-Commandで作成管理する (http://utility onnpass.com/event/9512/)

HPCの構成

- ヘッドノード

- 計算ノード

- ストレージノード lustre OrangeFS

- WANの高速化ソリューション skeed , aspera

c3.8xlarge 1,656ノード

484.2 TFLOPS

TOP5000 64位 NOV 2013

一時間当たり約29万円

実行性能が上がってきている。Efficiency

レイテンシーで性能変わっている。レイテンシが短くなっている

AWS専用に強化されたCPUを搭載したC4インスタンス発表

空く具合で定価の1/10で利用可能

現行だと1.8倍速くなっています。 c3 > cr1

オンプレよりもC3の方が速い

GPUインスタンス

Hour単位で

グラフィックスで使えるのかお試しでも

G2 + XenApp

クラウド上のGPUで

HPCの紹介

- CieSpace

AWSでSaaS

- OpenFormで計算

流体形跡

- PLEXUS CAE

ブラウザだけで計算

- NEC HPC Online

計算リソース

- VT-HCM2

VisualTechnology

HPCクラウドを支えるインテルの技術

ビジネスを効率化するツールからビジネスそのものになってきている

コンシューマーから発信してくるデータが増えてきている

IoT、センサーからのデータ

街角のカメラ

工場の中のデータ

増えてきている

膨大なデータの処理

パラレルデータベース、サーチ

莫大なデータを扱うアプリケーション

HPCへのニーズも

研修所だけでなくてもハイパフォーマンスコンピューティングのニーズも

Xeon がHPCの核

集積回路 トランジスタのサイズが小さく

今後も

小さくなるメリット 実装面積も増やせるし、消費電力の削減、物理的な距離も短く

E5-2600 v3

18個のコア

電力管理の工夫

メモリ DDR4

新しいフューチャーも

浮動小数点の演算も進化

ベクトル演算ユニット

浮動小数点 356bit幅

FMA( Fused Multiply-Add) 乗算と演算を同時に

90% Linpack

120% SPECjbb 2013-M

暗号化処理の向上も

消費電力も上げっていない

E5 2666 v3

AWS専用

本田技研工業におけるHPC on AWSの歩み

re:invent 2014のリピートセッションになります。

[slideshare id=41528400&doc=bdt201-141113144712-conversion-gate02]

Local、スピード感ですすめてきた

それぞれのスパコン

が

グローバル化、効率化、生産開発体制、CAEのリソース 一カ所で集約

いろいろな研究、作っている

細かい要望も多い、製品になっていないものも

さまざまなリクエストに答えるのが難しくなってきた

量産系も研究開発が優先

基礎研に割り当てるのも難しい

答えることに行き着いたのがクラウド

一週間だけ使うのも

2012夏

社内でも調達できず、社外に目を向けた

ユーザがもとめている三ヶ月で終わらない

審査とか

いがいに使えるところがない

リードタイム

スピードに答えられるか

待てない、今過ぎ使いたい

柔軟性

止めたいとき止めたい

時間単位で貸してくれるのも

最新のCPUも

スパコンは新しいコアが使いたいニーズにも答えられる

スポットインスタンスも

[slideshare id=41572733&doc=spot301-141114135304-conversion-gate01]

リソースの5倍持っている

AWSは、1AZ、1DCに五万台

HPCでクラウドでAWSは避けられない

うまく使えるように

速く使ったほうがいいのを伝えたい

電力の問題

オレゴン、EUフランクフルト カーボンフリー

これも1つの魅力

Cluster manager job schedular

Computing node スポットインスタンス or オンデマンド(スポットインスタンスですべてのリソースはカバーできないので、オンデマンドを併用しているとのこと)

計算が終わったら、、終了

1/3の期間で終了

ピーク時は16,000コア同時に使っている

70%のコスト際限

スポットインスタンスを併用する

スポットインスタンスはAZのキャパで起動できない場合があるので、オンデマンドと併用しているとのこと

オンプレでやったらい

非常に難しい

三ヶ月かかる損失も出さないと明確には出せない

調達コストは

16,000コア 16,000コア持っていないといけない 1/7

性能、ライセンス

ライセンスのビジネスモデル

商用ソフトウェアの対応がネック

InfiniBandをつんでいるものと同等

最大スケールまでは出せていない

今後に期待

ISVの反応が変わってきている。個人的な所感

でも、このあたりの進化はまだまだ

ユーザ主導型のエコシステム =クラウド

こうゆうものがほしい、 →サービスが増えていく →ユーザが増えていく →リリースの数も増えていく 加速度的に増えていく

リクエストも投げるのも手

声を上げる 変えることもでできる

クラウドリソースを使うべきか

計算リソースを持てないところも使えるようになる

変えないとついて行けない

5年後

クラウドはHPC使うのは当たり前

マルチクラウドの形でリソースを使って行ければと

会社の特徴も持っているクラウド業者も

ソフトウェアのライセンスの問題

性能などもある

考え方も変えていかなければならない

前向きにとらえてやっていくのがポイント クラウドユーザ次第

オンプレとクラウドをシームレスに

HPC分野も、AWSを筆頭に、クラウドは避けて考えることはできないと実感しました。IoTなどセンサーネットワークが今後広がっていることも考えます。