9/16 2015 、Amazon S3 Storage の低コストストレージクラスとして、「Amazon S3 Standard – Infrequent Access ( 以下Standard-IA) 1」が発表されました。Standard-IAは、頻度に取り出さないデータ、長期間のファイル保存、バックアップ、DR向けとなっています。

auditなどの監査ログ系、アプリログなどの利用と考えられた設計となっています。取り出し料金が$0.01/GBがかかります。

なお、Standard-IAと利用用途が重なるGoogle Nearline Storageについても、同様$0.01/GBがかかります。

ゾーン限定の低価格Storage「Durable Reduced Availability (DRA) Storage」に相当するものはS3にはない。

| AWS | Google Cloud Platform | ||||

| Standard | Standard-IA | Standard | Durable Reduced Availability

Storage |

Nearline

Storage |

|

| -1TB | $0.033 | $0.019 | $0.026 | $0.02 | $0.01 |

| 49TB | $0.0324 | $0.019 | |||

| 450TB | $0.0319 | $0.019 | |||

| 500TB | $0.0313 | $0.019 | |||

| 4,000TB | $0.0308 | $0.019 | |||

| 5,000TB | $0.0302 | $0.019 | |||

ネットワーク転送量は別途かかります。クラウドストレージへのアップロードはすべて無料。※GCPの場合、同じリージョン間のGCEとClud Storeageからのデータ取得は無料となっています。

S3の場合、バケットのライフサイクルポリシにTransitionsを設定させる必要があります。オブジェクトを更新してからxx日後にStandard-IAにするようにします。

{

"Bucket": "xxxx-logs",

"LifecycleConfiguration": {

"Rules": [

{

"ID": "test_STANDARD_IA",

"Prefix": "",

"Status": "Enabled",

"Transitions": [

{

"Days": 30,

"StorageClass": "STANDARD_IA"

}

]

}

]

}

}

aws s3api put-bucket-lifecycle-configuration --cli-input-json file://s3_standard_ia_lifecyclepolicy_config.json

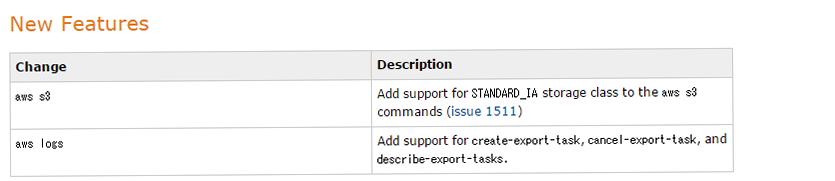

AWS CLIは1.8.6で対応しています。

リリース内容

1 https://aws.amazon.com/jp/about-aws/whats-new/2015/09/announcing-new-amazon-s3-storage-class-and-lower-glacier-prices/